在當今數據驅動的時代,構建一個實時的個性化推薦系統已成為眾多互聯網企業的核心需求。它能極大地提升用戶體驗、增強用戶粘性并驅動業務增長。本文旨在提供一個清晰的路線圖,闡述如何從零開始,系統地設計和開發一個具備實時推薦能力的個性化系統。

一、 核心架構與設計原則

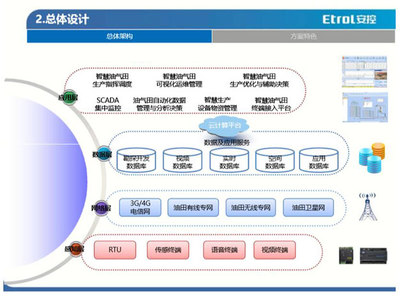

一個典型的實時個性化推薦系統通常采用分層架構,以確保模塊化、可擴展性和高性能。

- 數據層:這是系統的基石。需要整合多源數據,包括:

- 用戶數據:用戶畫像(人口統計、興趣標簽)、實時行為(點擊、瀏覽、搜索、購買)。

- 物品數據:商品/內容屬性、類別、標簽。

- 上下文數據:時間、地理位置、設備信息。

- 數據通常存儲在數據湖(如HDFS)或數據倉庫中,同時需要實時數據流(如Kafka)來捕獲用戶即時行為。

- 計算層:這是系統的“大腦”,負責生成推薦。通常分為兩部分:

- 離線/近線計算:處理海量歷史數據,訓練復雜的機器學習模型(如矩陣分解、深度神經網絡),生成用戶長期興趣模型和物品關聯關系。這個過程通常在分布式計算框架(如Spark、Flink)上周期性地運行。

- 在線實時計算:這是“實時”特性的核心。它負責:

- 實時處理用戶行為流,更新用戶的短期興趣向量(例如,使用Flink進行流處理)。

- 結合離線模型輸出的用戶長期興趣和實時更新的短期興趣,進行毫秒級的推薦結果召回與排序。

- 在線排序(Ranking)模型(如邏輯回歸、GBDT、深度學習模型)負責對召回的大量候選物品進行精排,綜合得分最高者呈現給用戶。

- 服務層:作為系統的對外接口,提供高并發、低延遲的推薦服務。通常是一個RESTful API或gRPC服務,負責:

- 接收前端請求(包含用戶ID、上下文)。

- 調用計算層(特別是在線部分)獲取推薦列表。

- 應用業務規則(如過濾已購商品、推廣位插槽)進行最終調整。

- 記錄推薦日志,用于后續的效果評估和模型迭代。

- 存儲層:為不同需求提供高速存取。

- 特征存儲:存儲用戶和物品的實時/離線特征向量,通常使用Redis或內存數據庫,以保證毫秒級讀取。

- 模型存儲:存儲訓練好的離線模型文件,供在線服務加載。

- 結果緩存:對熱門或通用的推薦結果進行緩存(如使用Redis),減輕計算壓力。

核心設計原則:解耦、可擴展、容錯、可觀測(完善的監控和日志體系)。

二、 關鍵開發步驟

- 需求分析與目標定義:明確業務目標(提升點擊率、轉化率、停留時長?),確定評測指標(準確率、召回率、AUC、線上A/B測試指標)。

- 數據管道搭建:

- 建立批量數據管道,將歷史數據導入數據倉庫。

- 建立實時數據管道,使用Kafka等消息隊列收集用戶行為事件,并利用Flink/Spark Streaming進行實時處理與特征工程。

- 召回策略開發:實現多種召回通道,以平衡多樣性和相關性。

- 協同過濾:基于用戶或物品的相似度。

- 基于內容:根據用戶歷史喜歡的物品屬性推薦相似物品。

- 熱門/趨勢:作為冷啟動和多樣性補充。

- 向量召回:使用雙塔模型等深度學習模型,將用戶和物品映射到同一向量空間,通過近似最近鄰搜索(如Faiss)快速召回。

- 排序模型開發與迭代:

- 初期:可采用邏輯回歸(LR)等簡單模型,快速上線驗證流程。

- 中期:引入特征交叉,使用因子分解機(FM)、梯度提升決策樹(GBDT)。

- 成熟期:部署深度學習模型(如DeepFM、Wide & Deep、DIN),更好地建模復雜非線性關系和用戶興趣動態變化。

- 模型訓練需使用離線日志數據,并持續進行線上A/B測試優化。

- 實時反饋閉環:這是實現“實時個性化”的關鍵。設計流處理作業,實時解析用戶對推薦結果的反饋(點擊/忽略),立即更新用戶的實時興趣特征,并可能觸發對下一次請求的推薦結果的即時調整。

- 服務部署與運維:

- 使用微服務架構部署推薦服務。

- 實現特征、模型、服務的分離部署與獨立更新。

- 建立完善的監控告警系統,監控QPS、延遲、錯誤率及業務指標波動。

三、 技術棧選型建議

- 數據流:Apache Kafka, Apache Pulsar

- 流處理:Apache Flink(首選,狀態計算能力強),Apache Spark Streaming

- 離線計算:Apache Spark

- 特征/模型存儲:Redis, Memcached, Cassandra

- 向量檢索:Facebook Faiss, Spotify Annoy, Milvus

- 在線服務:Spring Boot (Java), Gin (Golang), 或高性能RPC框架(gRPC)

- 模型訓練框架:TensorFlow, PyTorch, XGBoost/LightGBM

- 部署與編排:Docker, Kubernetes

四、 挑戰與注意事項

- 冷啟動問題:對于新用戶或新物品,缺乏歷史數據。解決方案:利用上下文信息、熱門推薦、跨域信息遷移或強化學習探索。

- 數據稀疏性:用戶-物品交互矩陣極其稀疏。解決方案:使用深度學習、引入更多側信息(side information)。

- 系統延遲:實時推薦要求端到端延遲通常在100毫秒以內。需優化每一個環節,特別是特征讀取和模型推理。

- 評估體系:離線指標(如AUC)與線上業務指標(如CTR)可能不一致,必須以線上A/B測試結果為準。

- 工程復雜性:系統涉及數據處理、機器學習、高并發服務等多個領域,需要跨職能團隊緊密協作。

###

從零構建實時個性化推薦系統是一項復雜的系統工程,融合了大數據處理、機器學習和軟件工程的精華。它沒有一成不變的銀彈,最佳實踐是在清晰的架構指導下,采用迭代式開發,從簡單可行的方案開始,通過數據反饋不斷驗證和優化,逐步演進成一個強大、智能的推薦引擎。核心在于建立起一個能夠持續學習、快速迭代的“數據-模型-服務”閉環。